- 1

Joined: 01/09/2017

DeepSeek V3.2: Có phải LLM mã nguồn mở mạnh nhất hiện nay?

Điểm nhấn

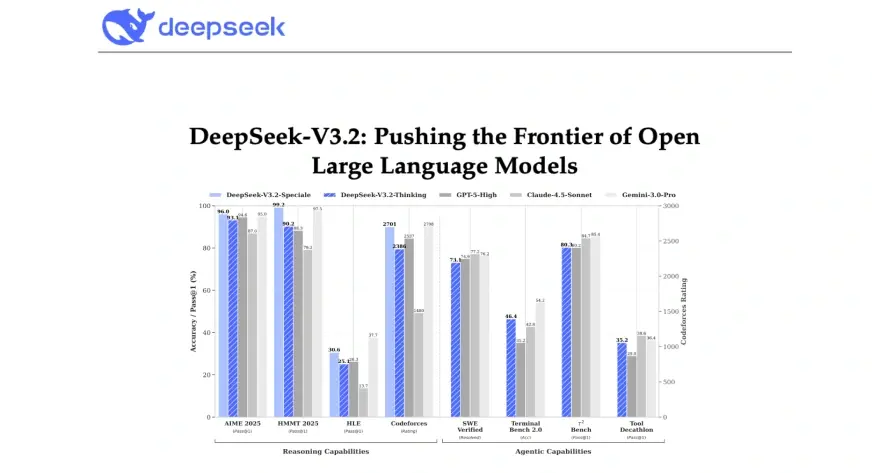

DeepSeek vừa ra mắt phiên bản V3.2, một bản nâng cấp thu hút sự chú ý mạnh mẽ từ cộng đồng phát triển AI mở vì những cải tiến về hiệu năng và tính đa dụng. Nhà phát triển công bố nhiều thay đổi ở kiến trúc và quy trình huấn luyện nhằm tối ưu khả năng hiểu-ngữ cảnh, tuân thủ hướng dẫn người dùng và xử lý tác vụ chuyên sâu như lập trình, trả lời chuyên môn và tạo nội dung sáng tạo. Nhưng câu hỏi lớn đặt ra: liệu V3.2 có thực sự là model mã nguồn mở “mạnh nhất” hiện nay hay không?

Những cải tiến kỹ thuật và điểm mạnh

Theo các thông tin công bố, DeepSeek V3.2 tập trung vào ba hướng chính: tối ưu kiến trúc transformer để giảm độ trễ, mở rộng bộ dữ liệu huấn luyện có kiểm soát (curated datasets) và áp dụng các kỹ thuật fine-tuning theo hướng dẫn (instruction tuning) cùng chiến lược điều chỉnh hành vi (alignment) gần với quy trình RLHF. Kết quả là model cho thấy khả năng trả lời mượt mà hơn với các yêu cầu phức tạp, cải thiện chất lượng mã nguồn đầu ra và giảm lỗi thực tế so với các phiên bản trước.

Cộng đồng đánh giá cao tính minh bạch trong tài liệu phát hành: model card, mô tả bộ dữ liệu, các kịch bản thử nghiệm và các tùy chọn quantization để triển khai trên phần cứng giới hạn. Tính linh hoạt khi tinh chỉnh ở quy mô nhỏ (few-shot và fine-tune nhẹ) giúp các nhóm phát triển dễ dàng tùy biến cho nhu cầu chuyên ngành.

So sánh với các đối thủ mã nguồn mở

Việc khẳng định mạnh nhất phụ thuộc vào tiêu chí so sánh: độ lớn mô hình, hiệu năng trên benchmark chuẩn, khả năng tuân thủ hướng dẫn hay tính đa năng trong ứng dụng. Một số model mã nguồn mở khác từng dẫn đầu ở một hoặc vài chỉ số chuyên biệt, và bảng xếp hạng có thể thay đổi tuỳ bộ benchmark sử dụng. Các bài thử độc lập cho thấy V3.2 cạnh tranh tốt trên nhiều tác vụ — nhưng ở một số phép đo chuyên sâu, các model khác vẫn có lợi thế về tốc độ thô hoặc hiệu năng trên tập dữ liệu cụ thể.

Yếu tố quan trọng là phương pháp đánh giá: so sánh công bằng đòi hỏi cùng điều kiện tiền xử lý, cùng chiến lược quantization và cùng nguồn lực phần cứng. Nhiều chuyên gia khuyến nghị nhìn vào chuỗi kết quả tổng hợp và thử nghiệm thực tế hơn là một con số duy nhất để nhận định “mạnh nhất”.

Rủi ro, hạn chế và tính bền vững

Dẫu có nhiều tiến bộ, V3.2 vẫn gặp các thách thức thường thấy ở LLM: nội dung không chính xác (hallucination), rủi ro đạo văn từ dữ liệu huấn luyện, và yêu cầu phần cứng khi chạy ở chế độ hiệu năng cao. Cộng đồng mã nguồn mở đang chú ý đến bản quyền dữ liệu huấn luyện và cơ chế báo cáo lỗi/hậu kiểm để nâng cao độ tin cậy.

Ý nghĩa đối với hệ sinh thái mã nguồn mở

Sự xuất hiện của V3.2 tiếp tục thúc đẩy cạnh tranh tích cực trong lĩnh vực LLM mở: nhiều tổ chức và nhóm nghiên cứu được khuyến khích đẩy nhanh cải tiến, đóng góp bản vá, tối ưu triển khai và phát triển các công cụ giám sát. Mô hình càng minh bạch về dữ liệu và quy trình huấn luyện, cộng đồng càng có khả năng rà soát, tái tạo kết quả và áp dụng thực tế an toàn hơn.

Kết luận

DeepSeek V3.2 là một bước tiến đáng chú ý trong làn sóng LLM mã nguồn mở, đem lại cải thiện thực tế về độ chính xác và tính linh hoạt khi triển khai. Tuy nhiên, gọi nó là “mạnh nhất” phụ thuộc vào tiêu chí đánh giá và nhu cầu cụ thể của người dùng. Đối với những nhóm cần một model mã nguồn mở có tài liệu minh bạch và khả năng tùy biến cao, V3.2 là lựa chọn đáng cân nhắc; nhưng để khẳng định vị thế tuyệt đối, cần thêm các thử nghiệm độc lập, so sánh trên nhiều benchmark và thời gian để kiểm chứng trong môi trường sản xuất.

Tham khảo thêm thông tin tại: Bài phân tích trên Analytics Vidhya, tìm kiếm mô hình và tài nguyên tại Hugging Face và tổng hợp kết quả nghiên cứu tại Papers With Code.

- 1